Je passe énormément de temps en R&D sur l'IA et j'avoue, ça me passionne… et ça m’amuse aussi beaucoup ! Mais, chaque lundi matin résonne le doux murmure des touches de clavier... et des grognements de Didier face à sa tâche hebdomadaire : la rédaction d'une newsletter (en l'occurrence la veille SEO de Soumettre.fr).

Mais pourquoi je fais ça ?

Je passe beaucoup de temps en R&D sur l'IA mais communiquer dessus n'est pas toujours facile. Je ne peux pas mettre en avant les projets clients et certaines de mes idées n'ont pas encore été testées en production. Alors, ce lundi matin quand Didier est arrivé dans le bureau, une tasse de café à la main et râlant sur la newsletter à rédiger, j'ai eu une idée...

Pourquoi ne pas vous montrer comment automatiser une newsletter ? Mais l’objectif est surtout de relever un défi : comment créer un système qui génère des newsletters tout en gardant le ton unique de Didier.

J'ai seulement les newsletters déjà publiées à ma disposition (200 environ). Mais même avec ce volume réduit de données, je vais vous montrer qu’il est possible d’automatiser intelligemment ce processus, en utilisant des techniques comme les GPT-Customs. Le but ? Vous montrez qu'il est possible de créer une empreinte de voix cohérente et personnalisée même avec une quantité de données limitée et accessoirement, éviter que Didier râle tous les lundis matin !

Et il râle encore... maintenant en me disant qu’il va devoir se filmer chaque lundi matin pour prouver que c’est bien lui qui écrit ! (Mais bon, si ça le fait râler, c’est que le résultat lui plaît, non ?)

Mission accomplie !

Ce projet m'a permis de constater que parfois la simplicité est la clé du succès. Après avoir cherché des solutions avec des méthodes de fine-tuning et de RAG, je me suis rendu compte qu'un grand nombre de tâches peuvent être effectuées avec des méthodes simples et rapides comme les GPT-Customs. Pour les habitués de la newsletter (que vous devriez rejoindre si ce n’est pas encore le cas...), c’est sûrement plus parlant.

Veille SEO 2025, semaine 12

Le printemps est là ! Les oiseaux chantent, les allergiques éternuent, et Google nous sort (encore) une nouvelle mise à jour de son algorithme. Histoire de nous rappeler que, non, ce n'est pas le moment de se détendre. Cette semaine, on parle de l’avenir d’Internet (spoiler : c’était mieux avant ?), de JavaScript SEO (parce que oui, ça complique tout), et de sponsoring de créateurs (cher, mais rentable).

Bonne lecture, et n'oubliez pas de vous amuser !

-

Google déploie la mise à jour principale de mars 2025

https://www.seroundtable.com/google-march-2025-core-update-39060.html

Google a appuyé sur le gros bouton rouge des Core Updates, le 13 mars 2025, qui devrait s'étendre sur environ deux semaines. Cette mise à jour vise à améliorer la pertinence des résultats de recherche en mettant en avant du contenu satisfaisant et pertinent pour les utilisateurs (Merci, ça aide.). Google a également mentionné son intention de promouvoir davantage le contenu des créateurs tout au long de l'année. Si vous perdez des positions, pensez à allumer un cierge. Ça peut pas faire de mal.

-

L'avenir d'Internet : fini la cour de récré ?

https://www.theverge.com/press-room/617654/internet-community-future-research

D’après une étude de The Verge, l’avenir du web, c’est les communautés restreintes et la personnalisation. En clair, les gens en ont marre des réseaux sociaux géants et préfèrent se regrouper en petits cercles de confiance. Est-ce que ça veut dire que les forums vont revenir à la mode ? Que Facebook va devenir un club de bridge pour boomers ? En tout cas, les marques et les créateurs de contenu vont devoir s’adapter. Parce que balancer des posts génériques à tout va, ça ne suffira plus.

-

JavaScript et SEO

[https://backlinko.com/javascript-seo

On le sait, JavaScript et SEO, c’est pas l’amour fou. Google a du mal à crawler du contenu qui n’est pas bêtement en HTML, et les sites modernes sont de plus en plus complexes. Résultat : si vous ne faites pas gaffe, votre contenu risque de ne jamais être indexé correctement. L’article de Backlinko liste les bonnes pratiques pour éviter le naufrage. TL;DR : assurez-vous que votre contenu est bien rendu côté serveur, testez vos pages avec Google Search Console, et croisez les doigts pour que Googlebot ait la patience d’aller au bout du script.

-

Ahrefs balance un million et tire les leçons

https://ahrefs.com/blog/sponsoring-creators/

Ahrefs a dépensé plus d’un million de dollars pour sponsoriser des créateurs, et devinez quoi ? Ça marche. Mais pas n’importe comment. Le secret ? Trouver les bons créateurs (ceux qui ont une vraie audience engagée, pas juste des chiffres gonflés à la sauce Instagram), leur laisser un maximum de liberté (personne n’aime les pubs forcées), et proposer une offre adaptée à leur audience. Bref, sponsoriser un créateur, c’est comme une relation amoureuse : si vous voulez que ça dure, il faut écouter, respecter, et éviter d’être un gros lourdaud.

Pour comparer, suivez le lien pour aller voir la newsletter rédigée par Didier ! Je pourrais encore améliorer le résultat en donnant pour chaque liens, l'avis en quelques mots de Didier afin de guider le modèle. ("Je suis d'accord avec l'article", "Ce chiffre est super important", "Explique qui est l'auteur car c'est important", "Google a encore craqué !").

Je teste pour LinkedIn

Pour vérifier si le GPT Custom pouvait être réutilisé mais en adoptant d’autres codes, j’ai effectué un test rapide pour générer un post LinkedIn en utilisant le ton de Didier à partir du lien d’un des articles de la newsletter et de son commentaire.

🔹 Google perd du terrain… et c’est tant mieux ? 🔹

Une étude signée The Verge et Vox Media vient de tomber : Google serait en perte de vitesse.

👉 Près de 50 % des répondants trouvent que le moteur devient moins utile.

👉 Résultat : ils vont chercher leurs infos ailleurs. Sur les réseaux sociaux, les communautés spécialisées… et les IA.

Le ton de l’article est un brin catastrophiste. Comme si on assistait à un effondrement du web, un exode numérique incontrôlable.

Mais en vrai, les anciens le savent (oui, je parle de moi et de ma barbe qui commence à blanchir) : avant Google, il y avait déjà des alternatives.

📌 Les flux RSS

📌 Les forums spécialisés

📌 Les canaux IRC et Usenet (ceux qui savent, savent 👀)

L’époque où Google décidait de tout, où tout passait par une seule entreprise privée, était une anomalie historique.

Alors si aujourd’hui, les internautes explorent de nouvelles pistes et diversifient leurs sources… c’est une bonne nouvelle.

📣 Moralité : notre business ne dépendra plus uniquement des caprices d’un seul moteur de recherche. Et si vous êtes déjà en train de bosser votre présence sur d’autres canaux… vous avez un train d’avance. 🚀

Et vous, vous le sentez aussi ce basculement ? Vous diversifiez déjà vos sources de visibilité ? 🤔 #SEO #Google #MarketingDigital #IA #Growth

Et pour twitter ?

🚨 Google perd du terrain ? Tant mieux.

Une étude The Verge montre que 50% des internautes se tournent vers les IA, forums, RS, RSS...

L’article sonne alarmiste, mais on revient juste à l’époque pré-Google.

Moins de dépendance à un seul acteur = plus de diversité !

Ces tests ont prouvé que la version customisée du modèle GPT permet de générer des contenus parfaitement adaptés à la personnalité de Didier, en respectant son ton et sa manière d'aborder les sujets.

Les méthodes qui n'ont pas marchés...

Pour réaliser mon projet j'ai étudié les méthodes les plus utilisées quand on parle d'IA.

Le RAG (Retrieval-Augmented Generation)

Le RAG est une méthode qui permet d’alimenter un modèle de langage (comme GPT) avec des données externes. Il combine génération de texte et extraction de données à partir d'une base de données ou de docs externes. Il est très utilisé en médecine, finance ou dans les domaines technologiques pour avoir une base de données actualisée et évolutives. C'est une méthode moins lourde que le fine-tuning à mettre en place.

Les limites :

- Le RAG a besoin d'une base de données de qualité et mise à jour régulièrement (minimum 10k lignes).

- Le RAG fonctionne sur le principe de recherche de similarité ce qui nécessite la création d'embeddings (transformation des données en vecteurs) et ce n'est pas toujours simples à mettre en place.

- Il n'est pas adapté à la création d'une empreinte de voix.

Pourquoi ça ne cadre pas avec mon objectif :

J'ai testé le RAG en local avec une base de données Chroma DB pour mieux comprendre les embeddings et le concept de similarité. Cependant, mon dataset étant trop petit, le modèle a eu du mal à s’adapter à mes besoins spécifiques. Malgré tout, cette expérimentation m’a permis de mieux appréhender ces concepts et de comprendre comment utiliser un fichier en Python pour interagir avec les embeddings et guider le modèle dans d’autres types d'entraînements (et je ne suis pas peu fière !).

Le RAG serait parfait si on voulait aller chercher des chiffres financiers, des résultats de recherche récents ou des tendances actuelles dans une base documentaire actualisée, mais il n'est pas adapté pour créer de nouveaux contenus en imitant un ton existant.

Le fine-tuning

Le fine-tuning est l'une des méthodes les plus populaires. Il permet de personnaliser un modèle pour une tâche spécifique ou un style particulier en l'entraînant sur un jeu de données supplémentaires. Cette méthode améliore les performances sur une tâche précise.

Les limites :

- Le fine-tuning demande une grande quantité de données en entrée : il faudrait un énorme dataset (entre 20k et 100K lignes)

- Si le dataset est mal dimensionné (trop petit ou trop grand), le modèle risque de sur-apprendre (overfitting), c'est-à-dire qu’il mémorise trop de détails ou qu'il a trop de bruits, dans ces données d’entraînement. Dans les deux cas c'est au détriment de sa capacité à généraliser sur de nouvelles données.

- Un autre facteur à prendre en compte pour éviter l'overfitting est sa complexité. Si le réseau neuronal comprend trop de couches ou de paramètres, il va devenir extrêmement performant sur son jeu de données, mais il sera incapable de s'adapter à de nouvelles données.

- Si les données sont trop homogènes, le modèle peut devenir trop rigide et spécifique. Il lui sera difficile de s'adapter à des situations variées, à de nouveaux contextes.

- Cette technique demande beaucoup de temps et de ressources, tant pour l’entraînement que pour la gestion des données.

Pourquoi ça ne cadre pas avec mon objectif :

Mon but est bien de réussir à reproduire un style particulier, mais je n'ai pas assez de données pour remplir mon dataset.

La méthode qui fonctionne : le GPT-Custom

Ma principale contrainte est un dataset limité, donc il est nécessaire de trouver une solution plus flexible et adaptée à cette situation. Comme j'utilise déjà régulièrement la customisation de GPT pour automatiser mes tâches quotidiennes, j'ai décidé d'enrichir mes méthodes habituelles en y intégrant des techniques que j'ai apprises au cours de mes recherches sur les RAGs.

Contexte :

Dans ce cadre, l'objectif est de donner des instructions claires au modèle en utilisant des techniques de prompt engineering pour l'orienter et le guider dans la direction souhaitée. Il n'y a pas de ré-entraînement du modèle, mais plutôt un ajustement de son comportement via des prompts adaptés, qui permettent de personnaliser la manière dont il répond et génère du contenu.

Méthode :

Je me base sur la base de connaissance et le contexte sous forme de prompts pour définir une empreinte de voix spécifique. En donnant des instructions claires au modèle, je peux générer du contenu cohérent avec le ton et le style souhaité, sans ré-entraîner le modèle. Cette méthode me permet d’obtenir des résultats personnalisés rapidement, en exploitant la puissance de personnalisation du modèle sans coûts supplémentaires.

Création du dataset

Objectif :

Étant donné que le modèle ne peut pas accéder directement aux données en ligne, il est nécessaire de les lui fournir de manière structurée. L'idée est de les organiser de façon à faciliter leur compréhension et à limiter la taille des documents dans la base de connaissances (donc moins de tokens en entrée).

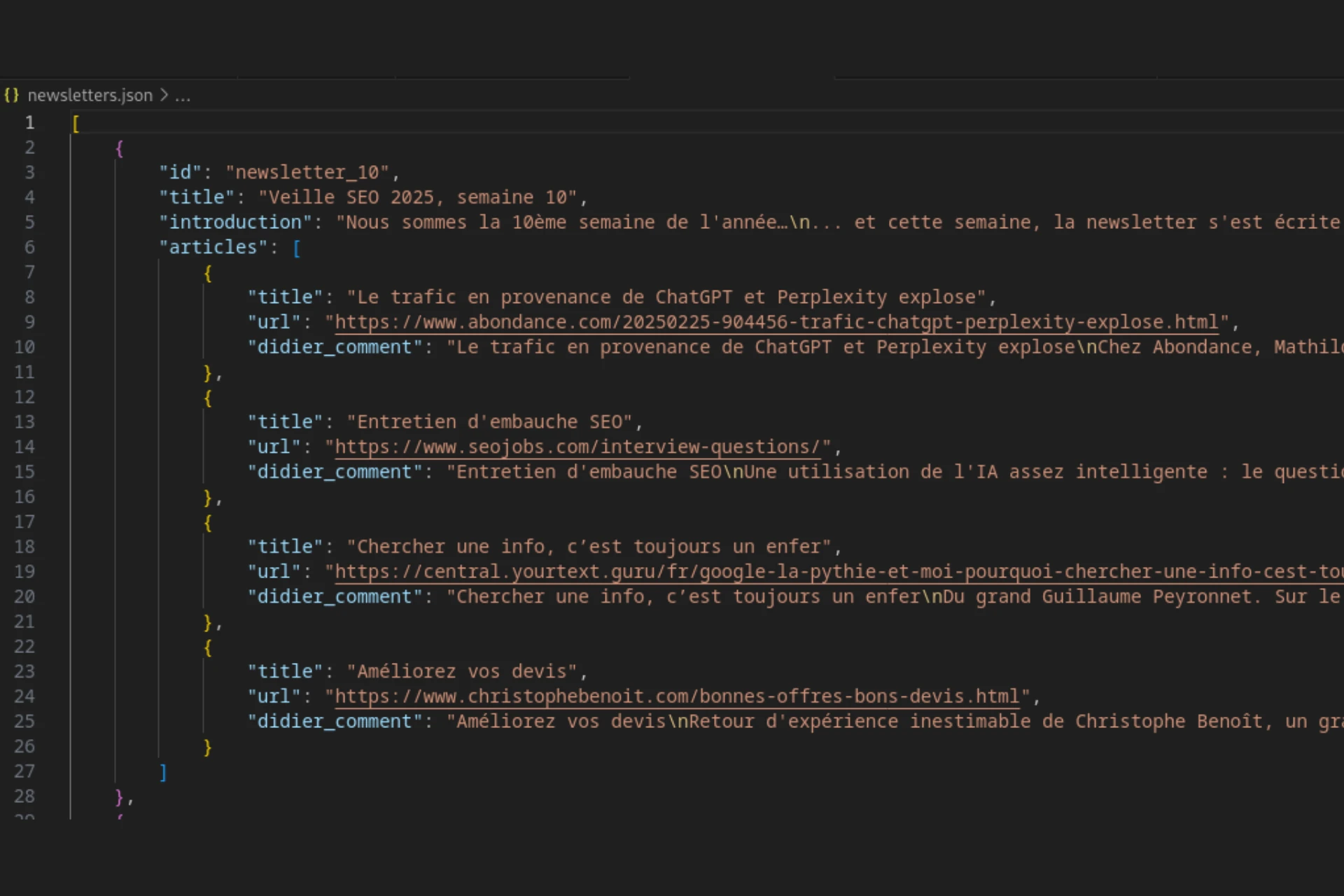

J’ai donc scrappé les anciennes newsletters publiées depuis bientôt 5 ans. Cette méthode permet d’extraire les éléments pertinents de la newsletter directement sur le site web. J’ai choisi de les structurer dans un format JSON, qui est un format de données léger et facilement manipulable.

Ce qui m'a permis de structurer chaque newsletter avec les informations suivantes :

- le titre de l’édition

- l’introduction

Et pour chaque article mis en avant :

- le titre

- l'URL source de l’article

- le commentaire de Didier

Analyse approfondie de mon dataset

Objectif : Cette étape remplace en quelque sorte l'entraînement du modèle. Mon but est de lui fournir assez d'informations pour qu'il puisse imiter la voix de Didier sans autres données en entrée.

Cette étape est la plus importante dans la réussite de mon test. Si l'analyse n'est pas assez précise et qualitative, il ne réussira pas à reproduire le style que j’attends. Si vous avez regardé la vidéo sur la génération d'image par IA vous avez vu à quel point, il est important d'intégrer des éléments techniques à votre prompt. Pour les images, je vous avez parlé des besoins d'un photographe pour reproduire un cliché (réglages de l'appareil, les lumières, le point focal etc...).

Ici on va avoir besoin d'une analyse très poussée du style rédactionnel de Didier, pour un auteur :

- Le ton et l’ambiance générale (posture par rapport à son lecteur, rythme, autodérision, running gag identifiés...)

- La structure des newsletters avec quelques exemples pertinents

- La personnalité de l’auteur (ton affirmatif, ne ménage pas ses critiques, références subtiles à la culture geek...)

- Les biais rédactionnels et les spécificités du style

Mon analyse est beaucoup plus complète et personnelle mais le secret est de se mettre à la place de l'IA comme si, c'était vous qui devez rédiger cette newsletter. Cette analyse est ensuite ajoutée à la base de connaissance du modèle.

Une fois que vous avez identifié les champs nécessaires et le niveau de détail à donner, vous pouvez structurer votre analyse pour automatiser la création d'une voix à partir d'un autre jeu de données.

Le prompt pour les instructions

Principe :

Les instructions que vous pouvez donner au GPT-Custom sont limitées. Il faut les rédiger sous forme de prompt clair qui va guider le modèle étape par étape.

- Le but du modèle : générer des newsletters dans le style de Didier

- Les éléments sur lesquels il doit s'appuyer pour répondre : les analyses fournies en base de connaissance

- Les étapes à respecter dans l'ordre : commence par analyser ta base de connaissance, puis analyse des liens des articles avant la rédaction...

- Le respect des structures et des longueurs pour chaque élément à générer

- Les choses qu'il ne doit absolument pas faire

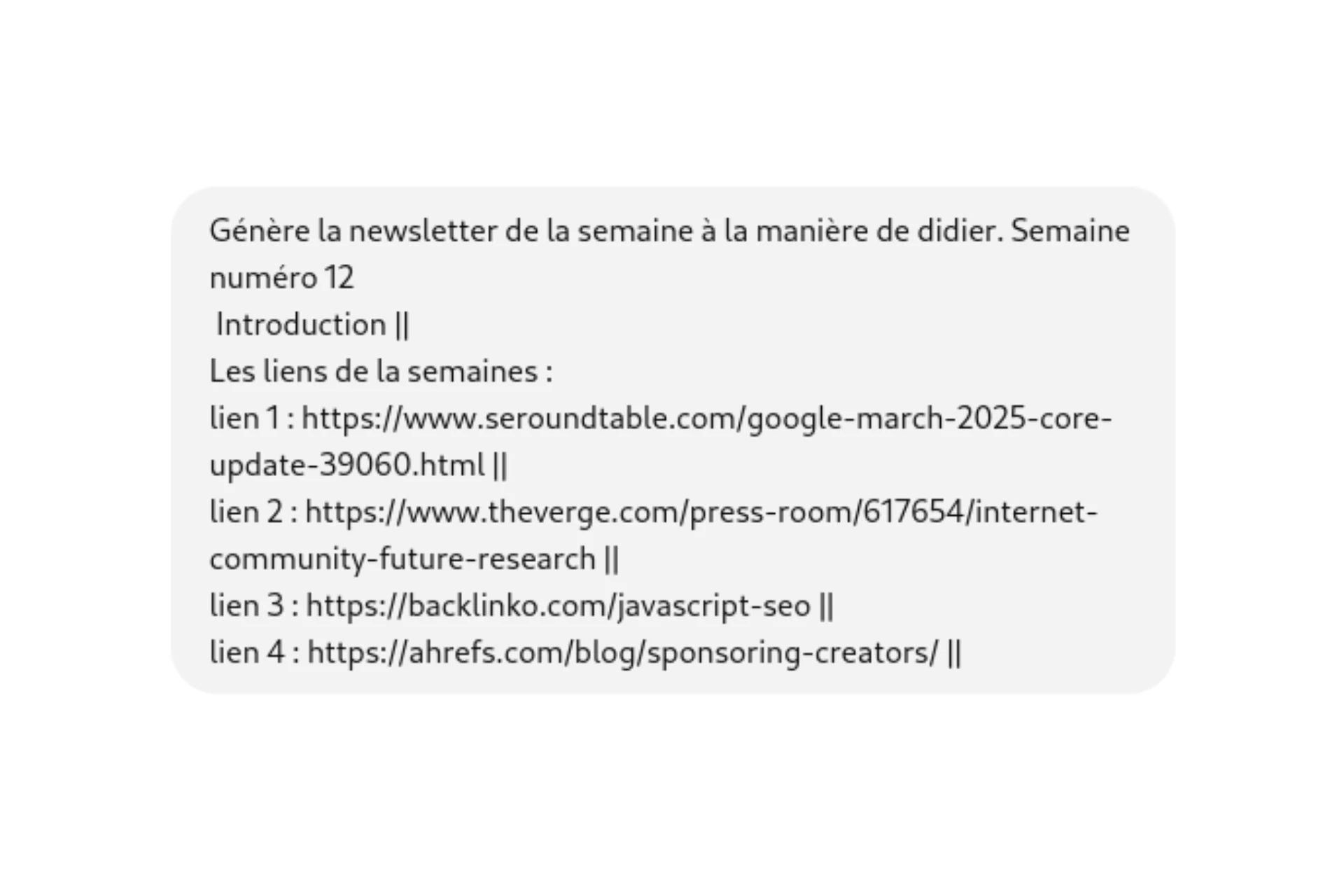

Le prompt pour l'interface de chat

Mon but est d'avoir un prompt le plus court et minimaliste possible dans le chat.

Si je le souhaite, je peux ajouter directement dans le chat des instructions spécifiques à chaque lien ou à l'introduction après "||".

Les limites :

- Cette méthode n'est pas Opensource

- Il n'y a pas de confidentialité des données

- On ne peut pas utiliser d'Api

- Les instructions sont limitées à environ 32000 tokens

- La compréhension du contexte est limitée pour des tâches complexes

- Il est impossible de scrapper des données directement pour enrichir sa base de connaissance

Pourquoi ça cadre avec mon objectif :

Mon dataset étant limité, cette approche est idéale. Elle me permet d'organiser mes analyses de manière structurée dans la base de connaissance. De plus, mes newsletters passées ne sont pas confidentielles, ce qui les rend parfaitement exploitables. L'interface de chat peut ensuite utiliser ces informations et naviguer sur internet pour analyser directement le contenu de nouveaux liens, tout en respectant la structure demandée.

Vous aussi, vous avez des tâches récurrentes qui vous font râler le lundi matin ?

L’automatisation est la clé pour gagner du temps. En fonction des données dont vous disposez et des résultats que vous souhaitez obtenir, il existe différentes solutions d'IA adaptées à vos besoins, qu'il s'agisse de fine-tuning, de RAG ou de personnalisation.

- Création de contenu personnalisé : rédigez des articles, des newsletters ou des posts pour les réseaux sociaux tout en maintenant votre style unique.

- Création de fiches produits : générez automatiquement des descriptions de produits optimisées SEO à partir des informations de base.

- Création de prompt : automatisez la génération de vos prompts récurrents comme les images ou les infographies.

- Réponses automatiques : automatisez les réponses aux emails ou aux questions fréquentes, tout en les adaptant à votre ton.

- Chatbot pour le support client : mettez en place un chatbot qui répond instantanément aux questions fréquentes sur les produits, les retours, les délais de livraison ou les besoins des utilisateurs.

- Analyse et synthèse de données : récupérez des informations pertinentes de vos sources et générez des rapports ou des résumés automatiquement.

- Création de quiz et tests automatisés : générez automatiquement des questionnaires et tests en fonction de vos données internes.

- Veille concurrentielle et gestion des tendances : automatisez le suivi des stratégies de contenu de vos concurrents, générez des rapports détaillés sur les dernières tendances du secteur.

En fonction de vos besoins, des solutions IA peuvent transformer des tâches répétitives en processus efficaces, vous libérant ainsi du temps pour des missions à plus forte valeur ajoutée. Ensemble, nous pourrons explorer comment ces technologies peuvent non seulement vous aider à optimiser vos processus internes, mais aussi à renforcer votre présence en ligne et à toucher plus efficacement votre audience.